人工智能时代,如何做设计?

本文作者:Josh Lovejoy,Google 的交互设计师

正如之前的移动互联网乃至再早之前的互联网都曾经改变人们的思考方式一样,机器学习 (Machine Learning, ML)让我们开始重新思考、重新构建并重新审视我们所创造的体验的可能性。在 Google 的用户体验社区中,我们也启动了名为 “以人为中心的机器学习 (Human-Centered Machine Learning)” 的项目,专注于这个领域的研究。在这里,我们聚焦于诸多产品,来观察机器学习是如何以其独有的方式来解决人类的实际需求。我们的团队试图让所有用户体验设计师们理解机器学习的概念,了解如何将机器学习融入到用户体验的知识体系中,并且确保我们以整合的方式构建机器学习及人工智能的实际体验。

△Google Clips 捕捉到的真实的父母、孩子及宠物的影像

Google Clips是一款智能相机,用于捕捉亲朋好友乃至宠物之间的甜蜜时刻。通过设备内置的机器智能,它能将镜头只聚焦于你关心的对象上,并且深谙美好且充满回忆的照片的构成要素。本文中,来自 Google 的交互设计师 Josh Lovejoy 将以 Google Clips 作为研究案例,和大家一起回顾三年中设备软件模型、工艺设计及用户界面打磨的历程,以及 “以人为中心” 设计一款人工智能驱动产品的核心思路。希望能对大家有所启发与帮助!

△Google Clips 允许你选择一个合适的相框区域 (如上图左边),并将其设为预览静态图 (如上图右边)。你只需要把相机夹在篮球框上,就能顺利捕捉下孩子灌篮的瞬间。

如果没有契合人的需求,那么你只是在创建一个强大的系统来解决一个非常微小的,乃至不存在的问题。

要知道的是,如果只是让更多的用户体验设计师们参与到使用机器学习的项目中是不够的。更重要的是,要让他们明白具体的机器学习的核心概念,抛掉对人工智能的固有偏见,并通过最佳实践来建立并维持信任。机器学习的整个生命周期的每个阶段都意味着创新——从模型构建决策到数据采集,到解读,再到原型和测试,都是如此。

我们列举了以下这些事实来证明,在构建机器学习驱动的产品及系统时,为什么 “以人为中心” 是非常重要的:

- 机器学习不能找出需要解决的问题。如果没有考虑到人的需求,那么你只是在创建一个强大的系统,来解决一个非常微小的,乃至不存在的问题;

- 如果 AI 系统的设计目的不明确,用户就无法明确理解他们在系统中的角色,以及该发挥什么作用,这会导致他们根据自身对 AI 的通俗理解来构建其心智模型,从而影响到对产品的信任;

- 一个成功的机器学习模型是多种约束条件合力的结果。从这个角度上看,机器学习模型的建立不仅拥有技术性的一面,也拥有 “社交学习” 的一面——每个人的成长,都是在同时适应诸多社会规则的过程。机器学习是根据从数据中自动总结出来的模式及关系来做出预判的科学,机器学习模型的任务便是弄明白这些数据模式中导向错误的概率,并规避之,从而尽可能做出最正确的判断。但这些过程并不是机器自己在做。我们更需要看到的是,机器学习的方方面面都是基于人为的判断来推动或调节的:从最开始的构建模型的想法,到选择用来训练的数据源,到设计用来解读数据的标签和方法,乃至最终获得的判断对或错的能力。这也再次印证那句在用户体验设计工作中备受推崇的至理名言——你不能代表用户。

一、在 “以人为中心” 的设计中,提升人工智能的三种途径

1. 解决人们真正的需求

如今,人们每年将拍摄数万亿的照片,对大多数人来说,这其实意味着一个我们实际上并不会看的,满是照片的数字 “画廊”。对于新晋的宝爸宝妈们来说更是如此,他们每天的生活中都有无数的 “第一次”。而人们往往倾向于拿出手机捕捉那些他们觉得珍贵而短暂的时刻,留存以供日后回顾。然而,这却导致他们最终只通过这一方小小的屏幕来看这个世界,而非通过自己的感觉与世界互动。

△作为一个新晋家长,你的照片时间线可能也是这样的——数张连续拍摄的照片,以图捕捉到最完美可爱的表情。

如果我们能打造一款能帮我们更好的留存这些美好时刻的产品,那会怎么样呢?如果我们能实际出现在照片里,而不是在相机后呢?如果我们能及时拍摄到我们想要拍摄的照片,而不需要停下来、取出手机、打开相机然后取景,还甚至会打破这些美好呢?如果我们能有一个实时相伴的摄影师来捕捉生活中美好时刻 (比如孩子的笑脸) 呢?——这些即使我们随时在镜头后都很难被捕捉到的时刻,才是我们想要为用户解决的需求。

2. 引导智能

当我们开始研究之后,最迫切的问题是:如果人们拍摄了大量的照片,但是懒得进行整理,那么我们要如何进行标记管理呢?这便诞生了基础的 “以人为中心的机器学习 (HCML)” 练习:描述一下理论上人类 “专家” 解决这个问题的步骤。这个理论包含两重含义:首先,如果是人无法解决的问题,那么 AI 也不能;此外,通过深入研究 “专家” 的方法,我们可以找到数据集、标签以及模型构架。

如果是人无法解决的问题,那么 AI 也不能。

我们能想到的比较合适的例子是婚礼摄影师,而后我们通过一个刻意弄得含糊其辞的招聘公告 (“绝密项目!需要摄影!”) 来进行招聘并面试。通过反复试验试错,以及一些运气,我们最终发现了一个比较理想的专家组合——包括一位纪录片导演、一位新闻摄影记者和一位美术摄影师。然后我们将团队成员的影像作品汇集在一起,试图从中找出这个问题的答案——是什么元素造就了一个难忘的时刻?

△在评估照片和视频质量时,需要辨别其中的细微差别、审美本能和个人经历——这些我们常常认为理所当然的地方。譬如,每当 Josh Lovejoy 看到小儿子仔细研究一根弯曲的吸管 (见上图左侧),或者试图避开他的亲吻 (如上图中间) 时,就会崩溃。当他看到大儿子在公园里骑自行车的时候 (见上图右侧),感到非常自豪,因为记得那天开始他不再害怕骑自行车了。

3. 建立信任

之前,我们工作的出发点是,假设我们可以给这个 AI 模型提供我们认为好的及有趣的素材,然后它会据此来学会如何查找更多相关内容。这是将 “人机对话” 理想化的结果,包括景深,三分法则,打光,匹配剪辑,叙事等方面……但事实上,我们永远不应该低估人们运用常识的能力。

这些早期的实验暴露了巨大的技术和方法上的差距,让我们重新设定了对产品功能实现的猜想,并重新认识这项前所未有的工作的性质。对于我们的模型,我们也将从机器学习生硬地放在基础的位置上,转向明白只有在足够简化的框架下机器才能够有效地进行学习。这相当于,我们之前之所以碰壁,是因为我们试图教会一个两岁的小孩子读莎士比亚,而非 “Go, Dog. Go!” 这种简单的英语。这也就是 AI 最被神化的地方——存在一个单纯的 “智能”,可以理解所有的东西,并且将其概念化并根据场景具化成相应的知识。事实上真的是这样吗?不,差远了。

二、回到基础上来

一致性对于教学来说是最重要的。这也是我们在教孩子们学习读说英语时,为什么要尽可能解开他们对于 “O-U-G-U (例如 tough, through, thorough)” 的混乱 (一般这种词我们也不会放在一开始的时候就教) 。而相对的,cat、bat 以及 sat,由于其可预见的 “at” 读音,读写起来就有很高的一致性。

一致性通常伴随着自信心。试想一下,当老师列举出两个看起来不太一致的例子时,大多学生们都能非常快速并且渴望指出其不协调之处。但是算法无法提供这样的反馈。就算法而言,除非另有指示,否则对它显示的内容都具有相同的价值。对于 Google Clips 来说,这意味着不仅两个示例之间需要保持一致性,而是每个示例内部都需要一致。每个单独的帧都需要能代表我们想教会 ML 预测的那个分支,这往往表现为我们在教给 ML 应该忽略哪些帧。

1. 拍摄

我们需要训练这个模型,什么是糟糕的内容,例如手挡在了镜头前,镜头抖动以及没有聚焦等。

△我们使用上面的例子来训练机器学习模型来识别,相机是否放在口袋或钱包里了 (如左上图),还是手指或手挡在镜头前了 (如右上图) 。虽然这种训练并不能立刻生效,但是随着时间的推移,这将成为整个产品设计中非常重要的部分。通过排除掉这些无需关注的内容,拍摄的整体质量会直线上升。

2. 构图

同时,我们需要对模型进行稳定性、清晰度以及取景方面的训练。一不留神,脸部检测模型就会把位于整个取景框的右下角的人脸和画面中心的人脸同等对待。而这往往不是我们需要的结果。

△为了训练模型的主题连贯性,特别强调相关的例子是很重要的。我们可以比照一下上面两个场景:人物始终在镜头中心 (如上图左侧),以及只有 5% 的时间在取景框的中心 (如上图右侧)。

3. 社交常态

熟悉是摄影的基础。当你用相机对准某个人时,他们会通过微笑或者姿势来回应。更重要的是,选择取景并且按下快门的那个人是你,也就是拍摄对象熟知的那个人。然而对于自动相机来说,我们必须用算法来根据社交线索 (譬如说你与他们相处的时间以及他们在你镜头下的时间) 来判断谁才是你熟悉的人。

4. 编辑

当我们自己来拍摄照片时,多样和重复是很正常的,因为你脑海中总是有个声音在提醒你,“之前没见过这样的一面,该拍下来了!” 或者 “已经拍足够多了”。但是我们的模型无法作出这样的判断,它们需要更多的训练。

我们从三个不同的维度来处理这种多样性:

- 时间:拍摄的时长是一个非常重要的指标,没有捕捉到具体内容的话就不要长时间拍摄了,这很好理解。

- 视觉:颜色的微妙或剧烈变化都可以反映环境和活动的变化,试着去捕捉那些具有不同美学特征的时刻。

- 人物:你是处在一群人中,还是一个小团体,抑或是单独一人呢?了解有多少张熟悉的脸孔十分重要,这能让你感觉到并未错过什么重要的时刻。

△如上所示,Josh Lovejoy 把相机放在书架边上且镜头朝下,刚好能够拍到孩子们一起在搭建玩具。但这也意味着很长一段时间内,相机总是面临着相似的内容。在这种情况下,如何避免过多的重复拍摄,却不会错过精彩的瞬间,在现在与未来,都是一个非常复杂的用户体验课题。

△如上所示,Josh Lovejoy 把相机放在书架边上且镜头朝下,刚好能够拍到孩子们一起在搭建玩具。但这也意味着很长一段时间内,相机总是面临着相似的内容。在这种情况下,如何避免过多的重复拍摄,却不会错过精彩的瞬间,在现在与未来,都是一个非常复杂的用户体验课题。

三、信任和自我能效

我们投资 Google Clips 的原因之一在于,向世界证明基于设备内置及隐私保护的机器学习的重要性——更不用说其出色的性能 (譬如说,它需要更少的能耗,所以设备不会过热,进程处理更快且更为可靠,还不需要联网)。相机是非常私人的物品,我们一直在努力确保它——包括硬件、智能以及其产生的内容——都仅属于你自己。这也就是为什么,所有的一切都将留在相机里,除非你决定拿出来分享。

1. 概念框架

考虑到信任和自我效能,我们也需要格外留意 UI 设计的方式。在项目的开始,这意味着一些有趣的假设,关于一个 AI 驱动的产品应该如何 “出众”。

当我们大脑中开始思考关于未来科技的设计参考时,许多设计师总会联想到电影《少数派报告》和《银翼杀手》中的沉浸式的画面。但是想象一下,实际向用户说明类似《少数派报告》的 UI 是非常可笑的——在这,伸出你的手臂,等待两秒钟,然后握拳,手在这个位置逆时针旋转时然后右甩,是不是很容易! (才怪!) 几乎所有仿科幻的 UI 设计都犯了相似的错误——那就是交互模型的复杂性必须匹配其驱动的系统的复杂性,也就是说系统有多复杂,交互界面就该有多复杂。但这完全没有必要。我们在早期设计阶段也曾在这个死胡同里停留过,但我们现在已经很大程度上避免了这一点,原因有三:

- 我们在一个明显模拟的环境中向人们展示了假冒 / 假设的内容,在那里他们与他们看到的东西之间没有真正的联系。请注意,这并不是 AI 独有的问题:当你将用户投入到可用性实验中,这往往是其中一个混淆因素。

- 我们每天只顾着与说着相同语言的人在一起,一起思考 AI 的未来。但是却与其他人之间有了断层,没有将他人作为参考纳入到设计当中。

- 我们自认为设计非常棒,所以当用户没有马上认为我们的新设计非常酷,当人们没有迅速领会设计意图时,我们并不放在心上,给了自己相当大的宽容。

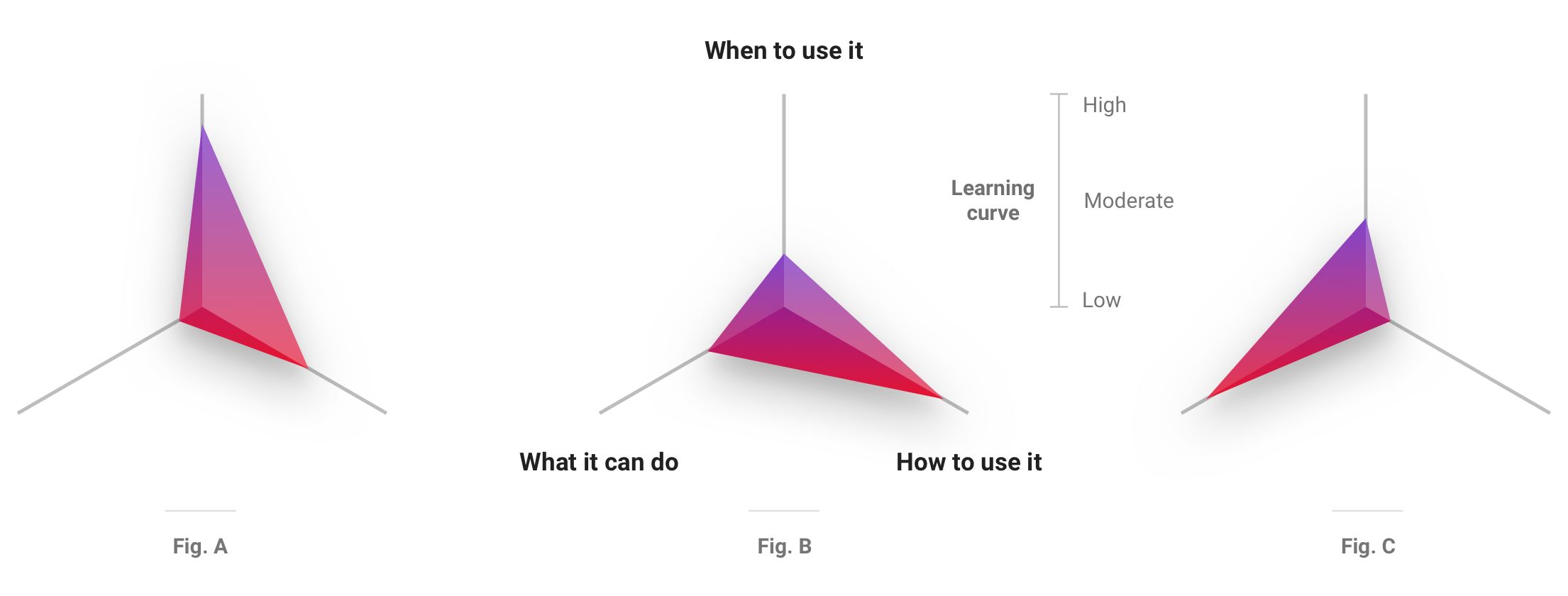

△大多数产品都有一个认知曲线的过程,但是外界对 AI 的过度宣传,使得对于用户的认知引导十分重要。当使用场景对用户来说十分新颖 (如上图 A) 时,那么需要着重关注其可靠性。如果有很多新的 UI 方面的设计 (如上图 B),那么要确保基本用例十分贴切。而当产品功能更加多元 (如上图 C) 时,你的 UI 设计则应该使用用户熟悉的模式。

随着时间的推移,我们逐渐走出了这样的局面。我们开始大幅降低 UI 设计的复杂性,并为我们的用户体验框架搭建了可控及熟悉的基础。所以我们为相机增加一个软件取景器及实体拍摄键,并确保用户对生成的图册拥有最终决定权。同时,比起展现 “恰到好处” 的内容,我们更倾向于向用户展现更多的内容。因为通过允许用户看到 “水面下” 的一些内容并且删除那些他们不想要的内容,他们才能更好地理解我们的相机试图要捕捉的那些时刻,也会对其之后的表现更具信心。 (再强调一下,这就是通过一些细节方面的心理博弈,来达成信任和自我效能。)

硬件,硬件中的智能及其产生的内容最终都仅属于你自己。

在这个过程中,我们有另外一个重要的发现:在创造之前,尽量模仿。如果必须二选其一,那么通过用户的真实内容来创建 UX 原型比用真正的机器学习模型来进行测试更加有用。因为后者需要花费更长的时间来构建和部署 (与传统的软件开发相比,其灵活性和适应性要差得多,所以调整和叫停的代价更高),而前者则可以为你提供真正的洞察,了解用户从你的 (理论性) 产品中获取价值和效用的方式。

△我们可以看到,用户可以通过滑动来预览照片,选择他们想要保存到手机的照片 (如上图左边),可以切换到查看 “推荐照片” (如上图中间),还可以精确选择他们想要保存为静态照片的那一帧 (如上图右边)。

在充满主观性及个性化的环境中,纯粹的完美是不可能的,也不应该成为我们的目标。与传统的软件开发相比,机器学习系统永远不存在 “绝对的正确”,因为预测本就是一门模糊的科学。但正是这种模糊使得机器学习十分有用。它帮助我们制定更为强大动态的 if 语句,使得我们得以根据“如果这个看起来像是x,那就做y操作”的规则来设计产品。在这种背离僵硬的逻辑规则的情况下,我们也同样需要抛下传统的度量互动的方式。Google Clips 的成功不仅仅在于保留,删除,点击和编辑 (尽管这些都很重要),而是在于其长期以来的协同创作,共同学习和适应与进步。我们衷心希望用户带上我们的产品,走出门去,享受生活。

四、带着目的来设计

我们可以通过对人工智能的重新定位,来寻找让机器更智能的途径并探索增强人类能力的方式,从而释放机器学习中更大的潜力。它可以成为一件强大的工具,来进行前所未有的探索及创新——一件帮助我们探索自己及周遭世界模式的工具。作为 “以人为中心” 设计项目的实践者,在人工智能的协助下,我们有巨大的机会来塑造一个更加人性化和包容性的世界,但这需要我们时刻谨记最根本的目的——寻找和解决人类真正的需求,力求维护人类价值,利用设计来强化人类的能力而非简单地自动化执行人类的工作。

是的,人工智能的作用不是直截了当的为我们锁定目标,而是为我们清除障碍,让我们得以更好地找到目标。

欢迎大家积极留言与我们互动,讲述你们对于 AI 时代下 UX 设计的心得或疑问。

原文:https://mp.weixin.qq.com/s/D5Tk3_SnyCbfAka6sNmGag

既然来了,说些什么?