从可视化到新模型:纵览深度学习的视觉可解释性

在本篇论文中,来自 UCLA 的研究人员就目前有关理解神经网络表征和用可解释/分离式表征学习神经网络的研究进行了一次调查。

本文将研究范围圈定到以下六个研究方向:

- 网络中间层的 CNN 特征可视化。这些方法主要是合成图像,使预训练的 CNN 中的给定神经元的得分最大化,或者用卷积层的 feature maps 反推出输入图。详细内容请看第二节。

- CNN 表征的诊断。相关的研究涉及为不同的物体类别诊断 CNN 的特征空间,或揭露卷积层的潜在的表征缺陷。详细内容见第三节。

- 「模式混合」的分离式表征编码在 CNN 的每个滤波器中。这方面的研究主要用于解卷积层的复合表征以及网络表征可视化。详细内容见第四节。

- 构建可解释的模型。我们在第五节讨论了可解释的 CNN 模型 [Zhang et al., 2017c],胶囊网络 capsule network)[Sabour et al., 2017],可解释的 R-CNNs [Wu et al., 2017],以及 InfoGAN [Chen et al., 2016]。

- 通过人机交互进行语义级的由中到尾的学习。CNN 表征的正确的语义解可以进一步实现弱监督下的神经网络的「由中到尾」学习。第七节介绍了一些通过人机交互来学习新模型的方法 [Zhang et al., 2017b] 以及通过有限的人机交互实现积极有效的问答游戏 [Zhang et al., 2017a]。

综上,CNN 表征可视化是探讨网络表征的最直接的方法。网络可视化还为许多诊断 CNN 表征的方法提供了技术基础。预训练的 CNN 的特征的分离式表征以及对可解释的网络表征的学习给最先进的算法带来了更大的挑战。

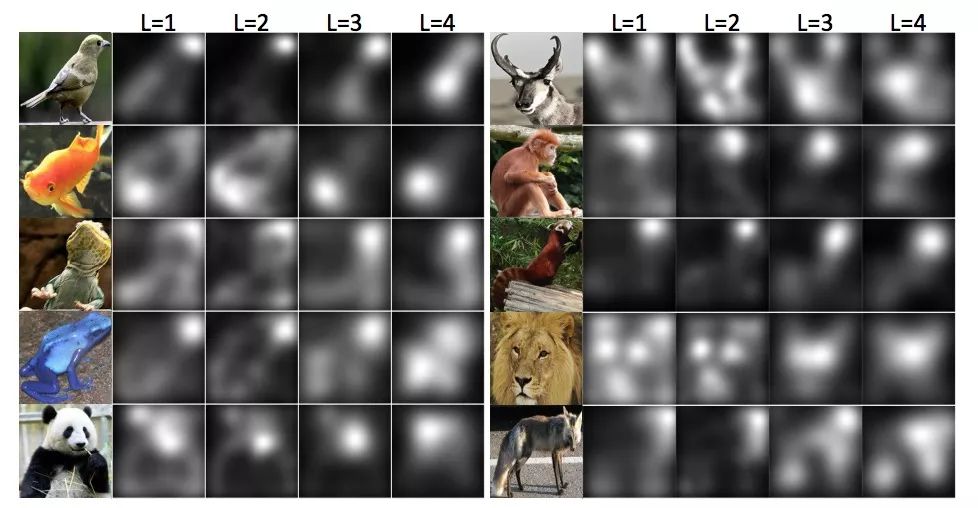

论文:Visual Interpretability for Deep Learning: a Survey

论文地址:https://arxiv.org/abs/1802.00614

摘要:本篇论文回顾了目前有关理解神经网络表征和用可解释/分离式中间层表征学习神经网络的新兴方向的研究。尽管深度神经网络在不同的任务中取得了不俗的表现,但是它的可解释性一直是深度神经网络的阿克琉斯之踵。当前,深度神经网络获得了很高的鉴别力,同时它也想黑匣子一样难以解释。我们相信良好的模型可解释性或许会帮助研究人员突破深度学习的瓶颈,例如,从很少的注释中学习,通过人机交互进行语义级别的学习,以及 debug 网络的语义表征。在本文中,我们重点关注卷积神经网络(CNN),并重新审视 CNN 表征的可视化,预训练 CNN 表征的诊断方法,预训练 CNN 表征的分离方法,CNN 的分离式表征学习,以及基于模型可解释性的从中到尾的学习。最后,我们将探讨可解释的人工智能的发展趋势。

2 CNN 表征的可视化

将 CNN 滤波器可视化是探索隐藏在神经元内的视觉模式的最直接方式。网络可视化已经有了各种各样的可视化方法。

- 首先,基于梯度的方法是网络可视化的主流方法 [Zeiler and Fergus, 2014; Mahendran and Vedaldi, 2015; Simonyan et al., 2013; Springenberg et al., 2015]。

- 其次,上卷积网络 [Dosovitskiy and Brox, 2016] 是另一种典型 CNN 表征可视化技术。

3 CNN 表征的诊断方法

一些方法超出了 CNN 的可视化和 CNN 表示诊断的范畴,以获得对 CNN 中编码的特征的启发式理解。我们将所有相关研究大致分为以下五个方面。

- 第一个研究方向是从全局角度分析 CNN 特征。

- 第二个研究方向是提取通过网络直接输出为标签/属性的图像区域,以解释标签/属性的 CNN 表征。

- CNN 特征空间中易受影响点的估计也是网络表征诊断的热门方向。

- 第四个研究方向是基于网络特征空间的分析来细化网络表征。

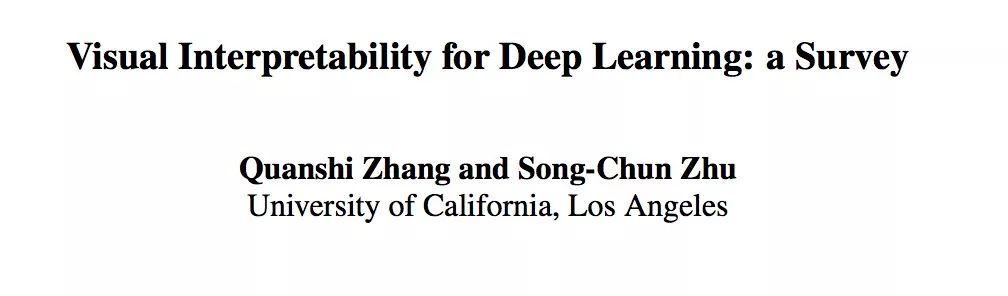

图 1 :CNN 中的偏置的表征 [Zhang et al., 2018b]

4 将 CNN 表征解构成说明图和决策树

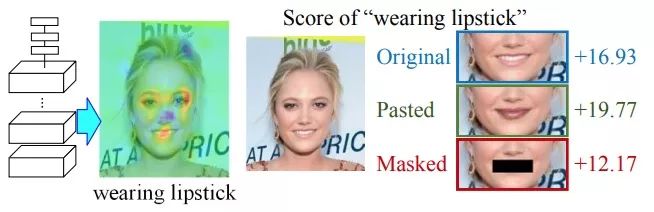

图 2 :不同的输入图像获得的滤波器的 Feature maps [Zhang et al., 2018a]。为了可视化 feature map,该方法将 feature map 中激活单元的感受野映射到图像平面。

图 3 :说明图 [Zhang et al., 2018a]。说明图表示隐藏在 CNN 的卷积层中的知识层次。预训练的 CNN 中的每个滤波器可以由对象的不同部分得到。

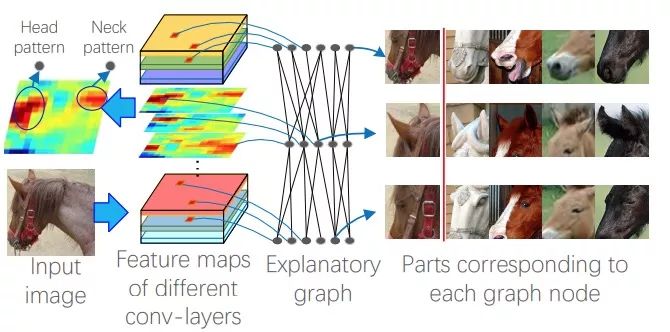

图 5:模式热点图 [Zhang et al., 2018a]。热点图将具有最高推断得分的说明图的第 L 层中排名前 50%的模式的空间分布可视化。

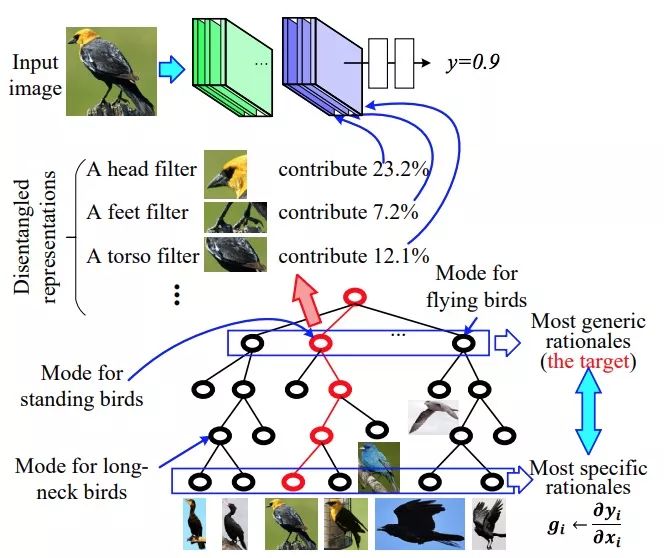

图 7:语义级 CNN 预测解释的决策树 [Zhang et al., 2018c]。CNN 学习在顶层的卷积层中运用分离式表征进行目标分类,其中每个过滤器代表一个特定的对象部分。决策树以由粗到精的方式编码隐藏在 CNN 全连接层内的各种决策模式。给定一张输入图像,决策树推断出一个解析树(红线)来定量分析 CNN 预测的基本原理,即物体的哪些部分(或滤波器)用于预测以及该部分(或滤波器)对预测有多大贡献。

5 用可解释/分离式表征学习神经网络

图 10:上层卷积层的可解释滤波器的可视化图 [Zhang et al., 2017c]。我们使用 [Zhou et al., 2015] 来估计 feature map 中激活感受野的图像分辨率以可视化过滤器的语义信息。可解释的 CNN 通常在其顶部的卷积层中对动物的头部模式进行编码以便于分类。

6 网络可解释性的评估标准

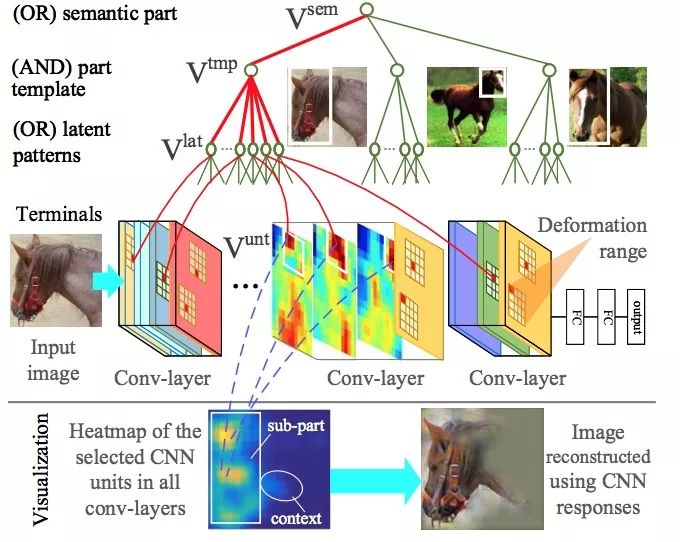

图 13:与或图在预训练的 CNN 上衍生为语义分支 [Zhang et al., 2017a]。AOG 将特定的 CNN 单元与某些图像区域相关联。红线表示解析图。

7 由中到尾学习的网络可解释性

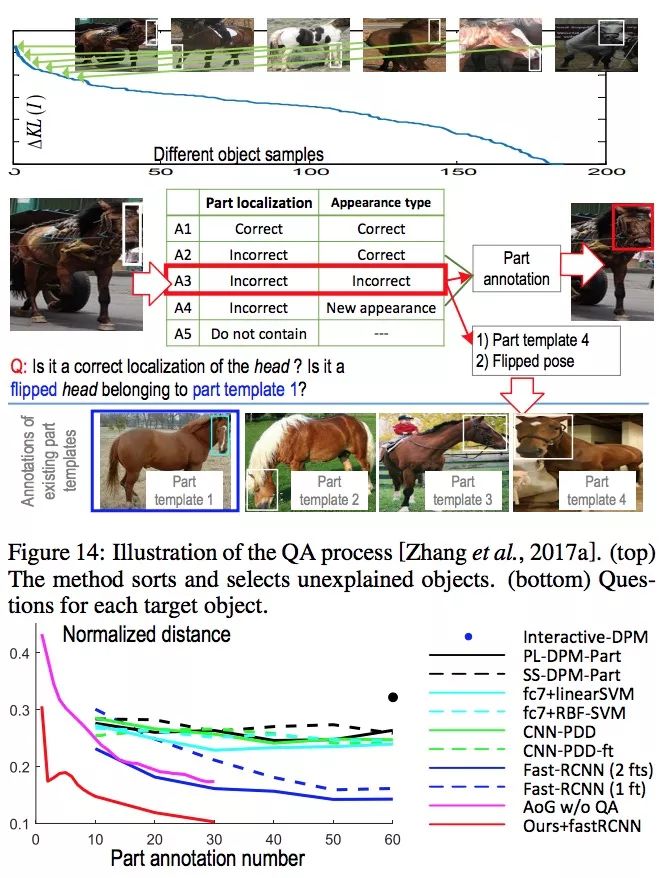

图 14:QA 过程的图示 [Zhang et al., 2017a]。(上)该方法选择不可解释的对象进行分类。(下)每个目标对象的问题。

原文:https://mp.weixin.qq.com/s/33VQNVvb7JGlk10Jc3mmeg

既然来了,说些什么?