标准化量表在可用性测试中的应用

1. 前言:

这篇文章是个人对当前可用性测试中常用标准化量表的学习和整理。整体架构参照Sauro and Lewis (2012)的《Quantifying the User Experience : Practical Statistics for User Research》。本文中大部分数据源于量表的官网或论文,部分则引用于该书。

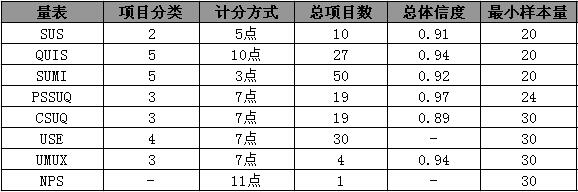

图1-1.量表初步总结

标准化量表和普通的问卷有什么区别:

a.标准化:(废话)量表的标准化意味着该量表的不会存在信效度缺失的问题,能够正确测量其想要测量的各个因子水平;

b.严谨:量表的问题/计分方式/分数解释是经过严格确定的,基本不存在为了分数解释而撕逼的情况;尽管大部分量表都表明可以按照需求增加或减少测试项目,但这对量表的总体信效度还是存在影响的;

c.量化数据:上述量表大多支持将分数转化为百分制,百分等级等等,便于进行统计分析、与非专业人员沟通和解释数据含义;

在可用性测试中,研究人员关注用户在测试过程中的表现和体验。在整个测试完成后完成相关的量表被称为测试后评估量表(Post-Study Questionnaire),而在每个任务后完成的相关量表被称为任务评估量表(Post-Task Questionnaire)。另外,有专门用于测试网站可用性的相关量表。

2. 测试后评估量表:

在使用量表时,分数的解释可以通过3个方法获得。1.建立产品的可用性基线,用于设定产品迭代/改善时的可用性目标;2.测试相同的任务,比较竞品与产品间的可用性差异;3.与现有的数据库对比,评判产品在整体行业中的可用性情况(部分量表不提供官方数据库)。

图2-1.测试后评估量表概览

2.1 系统可用性量表(SUS,System Usability Scale):

SUS最初发表于1986年,总共包括10个项目,包括5积极描述和5个消极描述。 Lewis and Sauro (2009)将其中8个项目归类于‘可用性(Usable)’,另外2个项目为‘可学性(Learnable)’。SUS的总体信度为0.92,其中可用性项目的信度为0.91,易学性项目的信度为0.7。

量表的全部项目采用从‘强烈不同意’到‘强烈同意’的5点评分。用户的最终作答将被转化为一个百分制的分数。其计算方式为:[Σ(积极描述得分-1)+Σ(5-消极描述得分)]*2.5。

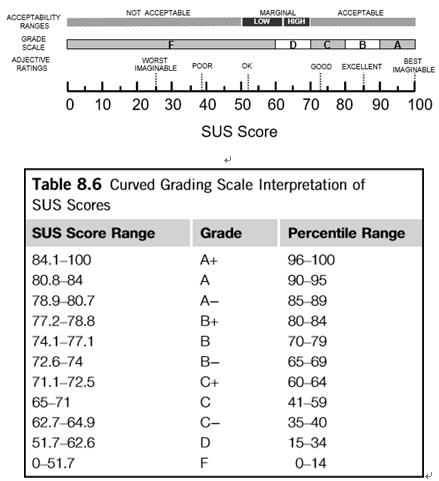

Bangor, Kortum, and Miller (2009)通过将SUS分数与一个7点的形容词评估想关系,将SUS评分划分了从F(<60)-A(>90)的5个等级。形容词评定和SUS分数之间的相关达到0.822,如图2-2(上)。

而通过整理SUS的相关测试,Lewis and Sauro (2009)提供了一个的从F(<51.7)到A+(>84.1)的11个等级,如图2-2(下)。此外,Lewis and Sauro (2009)还提供了积极版的SUS(全部项目采用积极描述),其信度达到0.96,与原版0.92的信度并不存在显著差异。(PS:这些人做等级的时候都把E跳过了…是有什么故事么…)

图2-2. SUS分数等级(Bangor et al. ,上;Lewis & Sauro,下)

2.2 用户交互满意度问卷QUIS(Questionnaire for User Interface Satisfaction):

根据官方描述,QUIS包括常用的简版和更为全面的长版。其项目分为两个模块。首先是总体评估,包括6个语义差异评级。其次是分类评估,其中简版包括界面,术语和系统信息,可学习性,系统能力四个部分,最多可达41个项目;而长版还包含有技术手册和在线帮助,在线教程,多媒体应用,电信会议及软件安装5个部分,最高可达122个项目。

根据其官网提供的27个项目的简版QUIS,研究者发现其总体信度可达0.94。尽管相较于SUS,QUIS的项目比较多,事实上该量表支持使用者根据自身的需要添加或删减测试项目,并且提供付费的数据库比对服务。

QUIS的项目均是采用9点的语义差异评级,通过计算各个分类的平均分和标准差来进行对比。在其官网可以找到更多关于数据分析的指导。

(官网:http://lap.umd.edu/quis/)。

2.3 软件可用性测试量表SUMI(Software Usability Measurement Inventory):

常用的SUMI总共包括50个项目,其总体信度为0.92。SUMI共5个部分,每部分10个项目,分别测量:

效率(Efficiency,信度0.81):产品在多大程度上帮助用户完成任务;

情感反应(Affect,信度0.85):在任务过程中,用户所经历的情感反应;

帮助系统(Helpfulness,信度0.83):产品在多大程度上是‘不解自明’的以及帮助信息的适用性;

可控性(Control,信度0.71):在多大程度上,用户认为产品是受到掌控的;

可学习性(Learnability,信度0.82):用户掌握产品/功能操作的速度。

SUMI最初采用5点评分,但在后期更改为‘同意’‘不确定’‘不同意’的3点评分。具体的计分方式不清楚,但其官方服务包括详细的数据分析报告以及数据库的对比。与QUIS一样,SUMI支持对可用性的不同部分(效率,情感反应等)的得分进行对比分析。

(官网:http://sumi.uxp.ie/index.html)

2.4 测试后系统可用性量表(PSSUQ, Post-Study System Usability

Questionnaire):

Lewis于1991年发表了PSSUQ,最初的量表包括18个,后面增加到19个项目。总共包括3个部分,分别测量产品的系统质量(System Usefulness,项目1-8),信息质量(Information Quality,项目9-15),和界面质量(Interface Quality项目16-19)。

PSSUQ的总体信度为0.94,三个分表的信度分别为0.9,0.91,0.83( Lewis, 1995)。

PSSUQ的计分方式为从1(强烈同意)到7(强烈不同意)的7点计分,可以计算所有项目得分的平均分得到产品的总体可用性得分,也可以计算各个部分的平均得分来判断产品在某个特定方面得分。PSSUQ的分数越低代表该产品的可用性越好。

Lewis (2002)分析了5年中共21个IBM可用性测试的数据。指出:1.PSSUQ的回答不完整不会影响其最终结果;2.绝对的PSSUQ总分的价值有限,关注不同分表的得分模式更有意义。同时,Lewis还指出测试者将PSSUQ的得分与其论文中的数据进行对比是没有意义的,因此也不存在PSSUQ的付费服务。

2.5 计算机系统可用性量表(CSUQ, Computer System Usability Questionnaire):

在发表PSSUQ之后,为了适应非实验室测试的测验环境,Lewis更改了其措辞编制了CSUQ。因此,CSUQ在项目数,计分方式等方面与PSSUQ是一模一样的。

CSUQ的总体信度为0.95,系统质量的信度为0.93,信息质量的信度为0.89,界面质量的信度则是0.89(Lewis, 1995)。

如果要在PSSUQ和CSUQ间作选择,则在实验室测试是选择PSSUQ,而在非实验室的测试环境时选择CSUQ。

2.6 有用性、满意度、易用性量表(USE, Usefulness, Satisfaction, and Ease ofUse):

Arnie Lund(2001年)发表了USE量表。测试4个部分,总共包括30个项目。其中的有效性(Usefulness)包括8个项目,易用性(Ease of Use)包括11个项目,易学性(Ease of Learning)包括4个项目,满意度(Satisfaction)包括7个项目。

量表的全部项目都是从1(不同意)到7(同意)的7点评分。其具体的统计方式和统计学参数尚未公开发表。但使用者可通过建立基线/竞品对比等方式来评测产品的可用性表现。

(量表链接:http://garyperlman.com/quest/quest.cgi?form=USE)

2.7 用户经验的可用性测量(UMUX, Usability Metric for UserExperience):

Finstad (2010)发表了UMUX量表。总共包括4个项目,其中3个分别测量ISO9241-11中对可用性的定义:有效性(Effectiveness),满意度(Satisfaction)和效率(Efficiency),以及1个测量综合体验的问题。

UMUX的计分方式为从1(强烈不同意)到7(强烈同意)的7点计分。其总分计算方式为(项目总分*2.5)。Kraig Finstad的研究指出UMUX分数与SUS分数间的相关性为0.80。

但作为新近编制的量表,UMUX的信效度受到了质疑。Bosley (2013)指出:1.对于测试可用性的量表而言,UMUX的结果标准差较大,表明其测试结果有较大的不稳定性;2.仅仅比较了可用性高和低的两个系统的分数与SUS分数的差异和相关性,对大多数可用性处于中等水平的系统没有进行对比。

2.8 净推荐值(NPS, Net Promoter Score):

顾名思义,NPS测量的是用户对产品的推荐欲望。NPS是对产品用户体验和用户满意度的一个整体的测量,它只包括一个项目(How likely are you to recommend (product or service) to a friend/colleague?)。

NPS并非一个单独的量表,它的问题项目来源于SUPR-Q(见下文),用户需要在0-10的可能性上进行评分。其中打分9-10的用户被称为推荐者(Promoter);打分在7-8之间的用户被称为被动者(Passive);而打分在6分以下的被称为贬损者(Detractor)。

NPS分数=(Promotor的百分比-Detractor的百分比)*100。

根据Sauro & Lewis(2012)书中提供的数据,NPS的分数与SUS分数呈现0.80的强相关,SUS分数超过80分即可被纳入为推荐者。

受限于问题的数量,NPS分数的信效度始终存在争议。样本的选取,措辞的改变等等都有可能影响到NPS的最终结果。

小结:

在上文描述中,本文整理了可用性测试中几种常用的标准化量表,包括其项目数、信度指数、分量表等信息。

在此总结:对于大多数情况,可选用SUS量表;如果需要具体测量产品某一方面的体验,应该选择QUIS、SUMI或PSSUQ;而对于非实验室测试,应当选择CSUQ;而对于时间有限或预算不足的项目可以选择NPS。

3. 网站评估量表:

网站评估量表产生的原因在于之前所提到的大部分整体评估问卷发表在网站流行的前期,因此会存在不适用的部分。比如:SUS,QUIS等问卷均不包括对产品的信任这一维度。而在使用网站的过程中,对网站提供内容和信息的信任无疑会影响到用户体验。

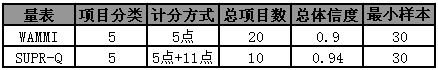

图3-1.网站可用性评估量表概览

3.1 网站分析和测量量表(WAMMI, Website Analysis and Measurement Inventory):

WAMMI包括20个项目,测量的因子与SUMI相同。WAMMI的总体信度在0.9-0.93之间,几个因子的测试信度为吸引力:0.64;可控性 0.69;效率:0.63;帮助性:0.7;易学性:0.74。相对于其它量表,这些分量表的信度有点儿偏低,因此WAMMI对于样本量有比较严格的规定:可用性测试不少于30人,学术应用不少于100人。

全部项目采用从1(强烈同意)到5(强烈不同意)的5点评分。在进行分数解释时,WAMMI推荐生成各个分量表的分数以及一个总分。其分数的标准化方式暂无公开发表,但标准化WAMMI分数的平均值为50,标准差为10。

WAMMI的付费服务包括在你的网站中增加量表的链接,可以申请将量表翻译成自己需要的语言。对于测试结果提供详细的描述报告及与其数据库的对比报告,但一般情况下不会返回原始数据(可以申请返回用户隐私数据之外的原始数据)。

WAMMI还提供一套附加的问题库,并允许自主增加项目,但不推荐对其原有的项目进行变更。

(官网:http://www.wammi.com)

3.2 标准通用的百分等级量表(SUPR-Q, Standardized Universal Percentile Rank Questionnaire):

根据官网的信息,SUPR-Q总共包括10个项目(Sauro & Lewis的书中是13个项目的旧版,在正式使用中可减少到8个题目),分别测量网站的可用性(Usability),可信度/信任(Trust & Credibility),外观(Appearance)和忠诚度(Loyalty)。

SUPR-Q的总体信度为0.86,各个分量表的信度分别是:0.88,0.85,0.78,0.64。SUPR-Q得分与SUS分数之间存在r>0.88的强相关,与WAMMI分数也存在r>0.88的强相关。

SUPR-Q的项目基本采用从1(强烈不同意)到5(强烈同意)的5点评分。但在忠诚度的分量表中‘项目:How likely are you to recommend (product or service) to a friend/colleague?’是采用从0(完全不可能)到10(极其乐意)的11点评分。这个项目也被人单独使用构成了NPS量表。

SUPR-Q的总分计算方式是所有项目得分的总和(NPS得分只计一半)。在进行数据库对比的时候,SUPR-Q的分数可以转化为百分等级分数进行判断。即,如果某网站的百分等级为80,则意味着该网站的SUPR-Q得分高于比数据库中80%的网站(官方表示有数据库中有150+个网站的数据)。

(官网:http://www.measuringu.com/products/suprq)

小结:

除了WAMMI和SUPR-Q之外,还有许多测量网站可用性的量表(Sauro & Lewis, 2012)。只是从应用层面而言,现在都在提倡‘移动优先’,而且大部分测试完全可以通过SUS或QUIS等量表完成,再辅以NPS或是测量信任度的题目。所以对于剩下的就不做梳理了。

4. 任务评估问卷:

可用性测试通常会包括有多个任务,而有的任务也会包含有多个分任务。研究发现整体评估和分任务评估间存在显著相关(r=0.64),但是如果想完全通过整体性评估的结果来解释测试结果仍是存在偏差的。

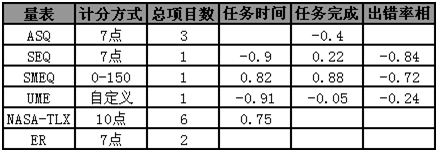

图4-1.任务评估问卷概览

4.1 场景后问卷(ASQ, After-Scenario Questionnaire):

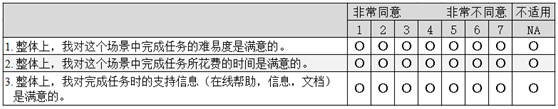

ASQ由PSSUQ和CSUQ的作者Lewis(1993)发表。总共包括三个项目,分别测量用户在三个方面的满意度:任务难度、完成效率和帮助信息。

ASQ的项目采用从1(强烈同意)到7(强烈不同意)的7点计分。ASQ分数即是3个项目得分的平均分。

Lewis (1995)的研究指出ASQ分数与PSSUQ分数的之间存在r=0.8的强相关,与场景任务的成功率也存在r=-0.4的显著相关。

图4-2. ASQ

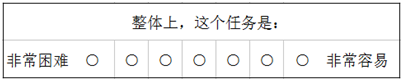

4.2 单项难易度问卷(SEQ, Single Ease Question):

SEQ是仅包括一个项目的语义差异测量,这个项目与ASQ的项目一类似,均是用户对任务难易度的评估。

SEQ的评分方式包括5点计分和7点计分,但根据目前的研究结果,7点评分拥有更高的信效度。

Sauro and Dumas (2009)发现SEQ分数与SUS得分呈现r=-0.56的的中等相关,与任务完成时间(r=-0.9)和任务出错率(r=-0.84)均存在显著相关性。同时,通过比较了SEQ、SMEQ和UME三个任务后评估问卷,他们也发现SEQ分数与SMEQ分数存在r=0.94的强相关,与UME分数存在r=0.95的强相关。

图4-3. Sauro & Dumas(2009)年发表的SEQ

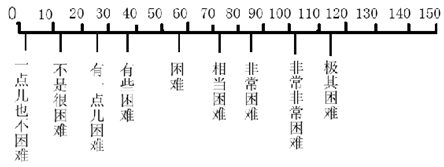

4.3 主观心智负荷问卷(SMEQ, Subjective Mental Effort Question):

SMEQ由Zijlstra & van Doorn(1985)年发表,仅包含有一个项目,是一个从0到150,包括9个文字标签的定距测量(Jeff Sauro & Dumas, 2009)。

与ASQ或SEQ不同,SMEQ的测量得分为定距分数。这意味着得分45与50之间的差距与得分120与125之间的差距是一样的,更加便于比较。

Sauro and Dumas (2009)发现SMEQ分数与SUS得分呈现r=-0.60的的中等相关,与任务完成时间(r=-0.82),任务完成率(r=0.88)和出错率(r=-0.72)均存在显著相关性。同时,SMEQ与UME分数存在r=0.84的强相关。

图4-4. SMEQ

4.4 可用性等级评估(Usability Magnitude Estimation):

UME由McGee(2003)发表,是仅包括一个项目的定比测量。

与其它任务后测量问卷不同,UME并不限定被测者的作答区间,可以是从绝对零值到正无限的任意值。这意味着50分的任务就是比25分的任务困难2倍,为解释结果提供了便利。

Jeff Sauro and Dumas (2009)的研究推荐了一种更方便解释和施测的方法,即为UME的评分定义基线。在研究中,他们将一个图标搜索任务的难度定义为10,被测者对任何测试任务的难度评估均以10标准点得出。

其研究中指出:UME分数与SUS分数呈现r=-0.316的轻度相关,与任务完成时间之间存在r=-0.91的显著相关。同时UME与SEQ存在r=0.95,与SMEQ存在r=0.84的强相关。

备注:对于UME的使用,目前仍存在着诸多争议。与其它问卷相比,UME更加依赖于主试人员;不同被试对基线的理解存在差异;训练被试理解‘两倍难度’,‘一半难度’等概念也会增加测试成本和误差。

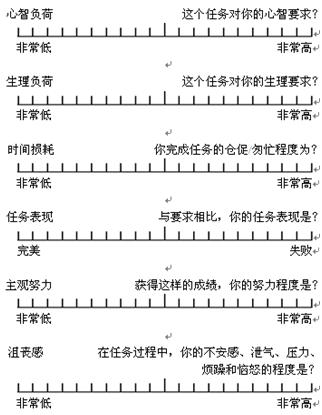

4.5 NASA任务符合问卷(NASA-TLX, NASA Task Load Index):

TLX由美国NASA研究中心发表,总共包括6个项目,分别测量用户主观的:心智负荷(Mental Demands),生理负荷(Physical Demands),时间损耗(Temporal Demands),任务表现(Own Performance),努力程度(Effort)和沮丧感(Frustration)。

标准的TLX施测程序包括两部分:首先,用户需要在每两个项目之间进行选择以判断任务负荷的来源(共15对),以确定各个项目在任务负荷中构成的权重;然后,则是在6个项目上进行的10点语义差异评分(用户在类似图4-5上的刻度上打分,处于两格之间的分数取靠右的值)。将项目的权重和项目评分相乘即为该用户的TLX分数。

当然,在正式使用时,也有研究省略掉权重评估的部分直接计算项目得分。

(官网:https://humansystems.arc.nasa.gov/groups/TLX/)

图4-5. NASA-TLX项目测量

4.6 期望评级(Expectation Rating):

Albert & Dixon(2003)年发表了ER问卷,他们认为任务的难度是与用户进行任务前的预期难度相关的。因此,ER包括两个项目:一个在进行任务前施测,测量用户对任务难度的预期判断;另一个在任务后施测,测量用户对任务难度的体验判断(Sauro & Lewis, 2012)。

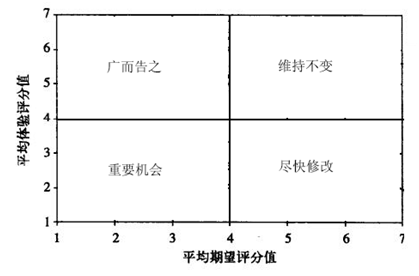

ER的项目采用从1(非常容易)到7(非常困难)的7点评分。与其它问卷比较最终得分的解释方法不同,ER的分数解释通过预期分数和体验分数两个维度构成的象限图来完成。如下:

图4-5. ER的分数象限

小结

在上述的几种任务评估问卷中,UME和TLX在分数解释上存在较高的成本,SEQ、SEMQ更适合在任务密集的测试中使用,ASQ和ER可能更适合时间较为充分的测试。此外,为了达到最优效果,参与测试的人数应不低于20。

结语:

可用性测试中适用的量表还有很多,Jeff Sauro and Lewis (2012)的书中详细介绍了这些量表的发展和使用。除此之外,书中还包括其它用户研究中统计及数据相关的信息(有中文版《量化用户体验的统计学方法》)。总结完以后再慢慢把量表翻译一遍。

作者信息:Ivan,2017届基础心理学硕士,福州。

参考文献

Bangor,A., Kortum, P., & Miller, J. (2009). Determining what Individual SUS ScoresMean: Adding an Adjective Rating Scale.Journal of Usability Studies(No.3).

Bosley, J. J. (2013). Creating a Short Usability Metric for User Experience (UMUX) Scale. Interacting with Computers(No.4), 317-319.

Finstad, K. (2010). The Usability Metric forUser Experience.Interacting with Computers, 22(5), 323-327. doi: 10.1016/j.intcom.2010.04.004

Lewis, J. R. (1995). IBM Computer UsabilitySatisfaction Questionnaires: Psychometric Evaluation and Instructions for Use.International Journal of Human-Computer Interaction(No.1), 57.

Lewis, J. R. (2002). Psychometric Evaluationof the PSSUQ Using Data from Five Years of Usability Studies.International Journal of Human-Computer Interaction, 14(3-4), 463-488. doi:10.1080/10447318.2002.9669130

Lewis, J. R., & Sauro, J. (2009).The Factor Structure of the System Usability Scale. Paper presented at the Human Centered Design, First International Conference.

Sauro, J., & Dumas, J. S. (2009).Comparison of three one-question, post-task usability questionnaires.Paper presented at the Proceedings of the 27thinternational conference on Human factors in computing systems.

Sauro, J., & Lewis, J. (2009).Correlations among Prototypical Usability Metrics: Evidence for the Construct of Usability.Paper presented at the27th Annual CHI Conference on Human Factors in Computing Systems.

Sauro, J., & Lewis, J. R. (2012).Quantifying the User Experience : Practical Statistics for User Research.

原文:https://www.jianshu.com/p/1292f8d835ed

既然来了,说些什么?